当毕业论文遇上AI检测,一场学术与技术的极限拉扯……

又到一年毕业季,毕业论文“AI率”成为热门话题。今年,不少高校首次引入“AIGC检测”机制,虽不是硬性的强制规定,但依旧引发诸多争议。部分学生反映,自己原创的论文被误判“AI率”过高,为通过不得不修改,既耗费金钱,又影响论文质量。

这一现象不禁让人思考:毕业论文AI检测究竟该如何定位?在AI时代,又该如何平衡学术规范与技术发展?

记者亲测:AI检测背后的“生意经”

当前,AI检测已催生出一系列相关服务。

记者在某智能降重平台实测发现,原本主打“查重”的服务已更新“降AI率”套餐。从5元/千字的“基础版”,到59元/篇的“AI无限次改稿”,已然形成了完整的价格梯度。

转战网购平台,输入“降AI率”便弹出多个商家链接。

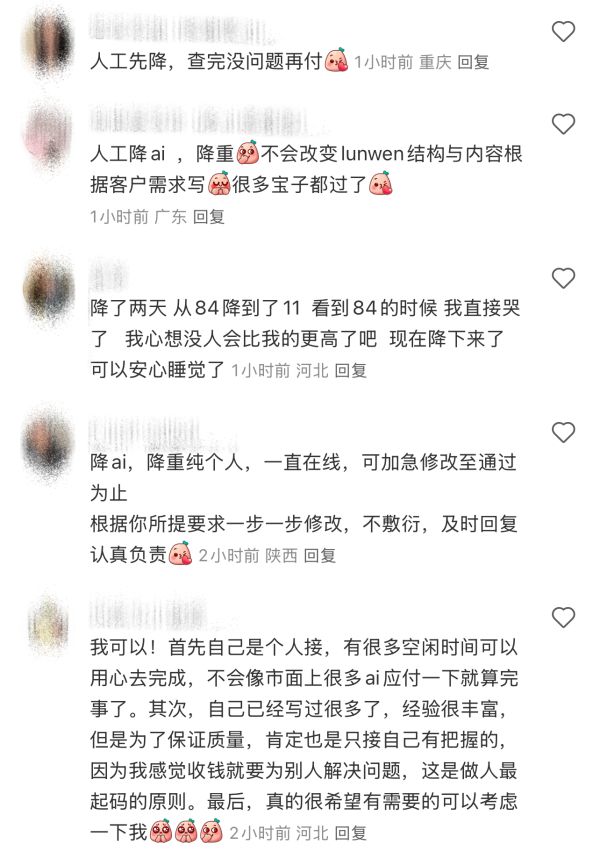

记者按照详情页上的操作步骤添加工作人员微信后,对方称自己是“专业做降低AI率服务”的,一万字论文从70%AI率降至40%收费140元左右,降到满意为止。

然而,这些商家在网购平台却是另外一副面孔,宣称“平台禁止咨询有关论文、作业、降重等学术内容,恶意咨询直接拉黑”。

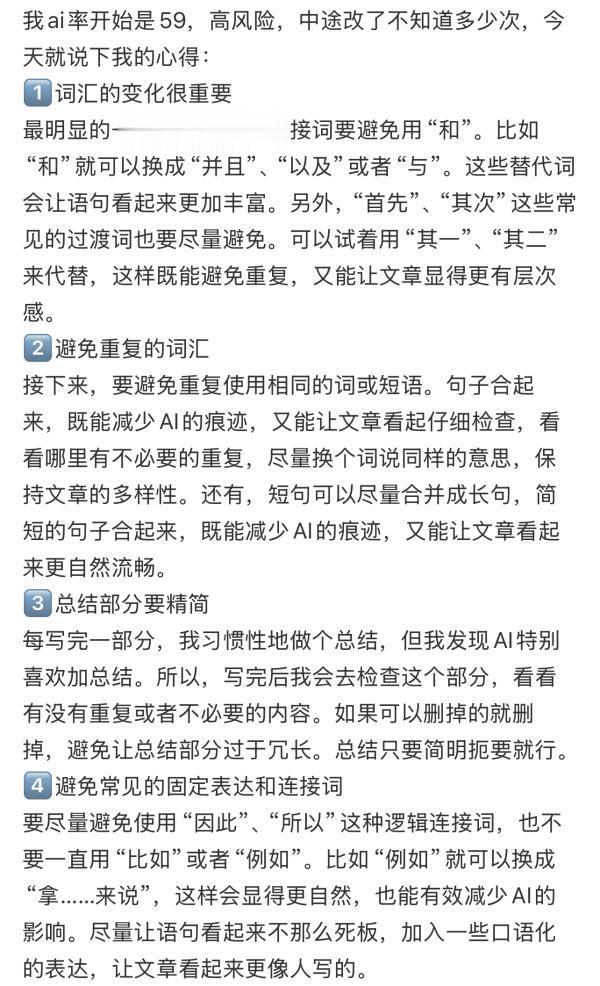

某社交平台已有数万+的相关经验分享帖。“适当删掉‘尽管’‘其中’‘比如’等衔接词”“对一些宽泛简单的文段进行扩写”“尽量避免采用总分总段落结构”等建议比比皆是。评论区则是毕业生们的一片哀叹:“改到怀疑人生!”“花了200块才过。”

记者在某平台上联系到一位可“人工降AI率”的发帖人,他表示,利用平台软件修改,有专业名词改错的风险,且后续极有可能被查出,他们人工降AI率则更注重语句表达,处理后需学生复检反馈,还称,“不会改变原文结构和意思,改到满意为止。”

当记者询问收费时,对方并没有给出单价,而是要求提供论文全文字数、需降低的AI率及检测系统等数据。

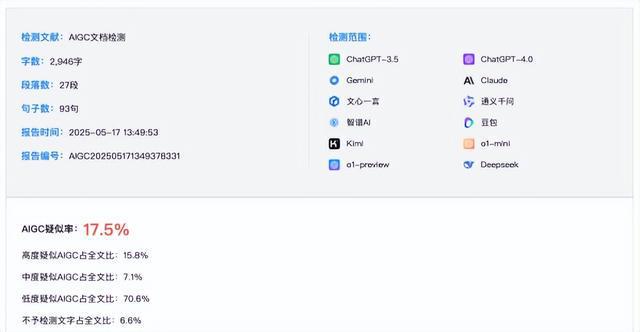

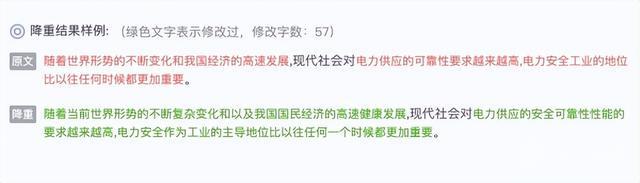

AIGC检测究竟靠不靠谱?记者打开常用的一款论文免费检测网站,上传了自己近期撰写的一篇未经发表的新闻稿,近3000字,检测结果显示AI疑似率为17.5%。检测报告还用不同的颜色来表示不同程度的疑似度范围。

难道是记者在段落中使用了较多的“虽然”“但是”衔接词吗?目前,谁也无法给出正确答案。

毕业生心声:AI检测带来的困扰与应对

南京师范大学应届毕业生周卉(化名)告诉记者,自己平时学习生活中,也会使用AI工具。

“生病抽完血,我会顺手把一些关键指标和症状丢给豆包、DeepSeek,问问情况;写毕业论文也会用其查询、总结资料。但我觉得AI输出的内容并不能完全信任,胡乱造词、数据落后等问题经常有,最终仍然需要人工仔细审核才能用。”

南京信息工程大学应届毕业生高子涵(化名)的论文“AI率”也较高,有40%。经过一段时间的修改,他总结出一些经验,“使用排比句、押韵的对偶、带冒号的并列句子,容易被判定为AI生成”。

这位子涵甚至还整理出了一套喂给AI的口令:请将这段话改写,通过调整语序增减字数,替换同义词等方式,避免与原文出现连续三个相同的句子,使这段话更有逻辑性,符台论文规范,尽量避免使用“和”“因此”“首先”“其次”“所以”这类词。

南京财经大学一名新闻学硕士研究生则认为,当前社交平台可能存在对“AI率”过度焦虑的问题,“那些说AI率高的帖子很大程度上是软广。”

导师心声:合理引导AI使用,关注抄袭分辨

南京大学外国语学院准聘副教授施雪莹表示,南京大学已在校级层面发布《本科生规范使用人工智能工具指导意见(试行)》。外语学科作为语言专业,本科毕业论文要求用法语直接写作,语言运用能力是检验学习成果的核心标准,所以对待AI辅助写作的态度会更加谨慎。

“学生实际语言水平如何,老师一眼就能看出来。个人观察,外语学习有个明显的‘分水岭’。就算学生能流畅地进行日常法语对话,但若要达到能够用外语进行复杂逻辑思考和论证的程度,难度还是相当大的。要是论文里有哪个段落突然‘文采飞扬’起来,我们马上就能察觉异常。再者,指导老师都会留存学生写作过程中的草稿,前后表达水平的变化根本藏不住。”

施雪莹认为,学校出台相关文件,并非要“一刀切”地禁止学生使用人工智能工具,而是引导大家正确合理使用。“核心要求是,学生用AI辅助需先征得导师同意,并明确说明使用情况和方式。”

那么,毕业论文考察“AI率”究竟是为了什么?南京航空航天大学人文与社会科学学院教授王立志认为,看似是查重导致了学生的焦虑情绪,但如何精准、有效地分辨抄袭行为,才是当前亟需解决的根本痛点。

“检测工具的可靠性,取决于算法逻辑。要查AI写的内容,需了解不同AI模型的写作特点,目前市面上没有绝对权威的检测工具。尽管如此,我们也得坚持用AI检测,总有些学生想偷懒用AI直接生成内容,这样可培养不出真正的人才。”王立志补充道,合理使用AI,老师不反对,如查资料、改错别字,这些基础工作交给AI没问题,但核心写作必须学生自己来,不能让AI代笔。

行业与专家观点:检测技术、标准与教育新哲学

一位人工智能行业从业者向记者介绍,当前主流的AIGC检测模型基于生成式大型语言模型(LLM-Large Language Model)技术框架,这类检测方法的本质是计算待测文本的生成概率值,也就是评估该文本由AI模型产出的可能性。

“其技术原理在于,大语言模型生成的文本具有特定的模式特征,与人类自然表达存在系统性差异。虽然个别语句可能达到以假乱真的程度,但当文本长度增加时,AI生成内容在逻辑连贯性、行文规范性和词汇分布规律等方面,会明显暴露出与训练数据强相关的特性,这些特征与人类写作习惯形成可辨识的差异。”

针对AI工具的“算法黑箱”特性,业内人士表示,算法解释工作很重要,但普通用户缺乏技术认知,模型部分运行机制虽具可解释性,但训练者也无法完全预测模型在特定场景下的输出,这是不可解释的最大挑战。

此外,王立志教授还指出,市面上AI检测工具检测原理和标准多样,缺乏统一测评标准,导致市场乱象丛生。传统思路是,AI公司应公开算法,但AI的“算法黑箱”问题使普通用户难以理解,算力成本高、算法有随机性、用户理解能力有限,彻底解释清楚AI算法几乎不可能。因此,建立科学的测评体系是更实在的治理之道,既能监控AI风险状况,又能满足多方面需求。

随着DeepSeek等大模型逐步逼近技术奇点,高校正站在教育范式转型的十字路口。南京信息工程大学教授、江苏省科普作家协会常务理事刘玉柱提出,应将AI工具使用纳入通识课程,强化“提问 - 验证 - 重构”的数字素养训练;研发AI内容检测系统,建立分级引用标准;明确科研创作中AI的贡献度计量方式。

江苏广电总台荔枝新闻中心 记者|刘正则

编辑|汪泽